WangLab at MEDIQA-Chat 2023: Clinical Note Generation from Doctor-Patient Conversations using Large Language Models

Abstract

本文描述了我们对Mediqa-Chat 2023共享任务的提交,该任务用于从医患对话中自动生成临床记录。 我们报告了两种方法的结果:第一种方法在共享任务数据上微调预先训练的语言模型(PLM);第二种方法在大语言模型(LLM)中使用少量上下文学习(ICL)。 两者都实现了通过自动度量(例如Rouge,BertScore)来衡量的高性能,并分别在共享任务的所有提交中排名第二和第一。 专家的人类审查表明,通过基于ICL的方法和GPT-4生成的笔记与人类书写的笔记一样经常被首选,这使得它成为从医患对话中自动生成笔记的一条有希望的途径。

1 Introduction

日益增长的临床文档负担已经成为医疗保健中的一个关键问题,增加了临床医生的工作不满和倦怠率,并对患者体验产生了负面影响。

通过医患对话生成电话记录,MEDIQA-Chat dialgue2note共享任务被提出。我们探索了两种方法; 第一种,微调一个预先训练的语言模型(PLM,§3.1);第二种,使用少量的上下文学习(ICL,§3.2)。 这两个都实现了很高的性能,由自动自然语言生成度量(§4)来衡量,并分别在共享任务的所有提交中排名第二和第一。 在一项由三位专家医生进行的人类评估中,通过基于ICL的方法和GPT-4生成的笔记被首选,其频率与人类书写的笔记一样(§4.3)。

2 Shared Task and Dataset

MEDIQA-Chat 2023中包含对话总结和根据医生和病人之间的对话生成病历

2.1 Task definition

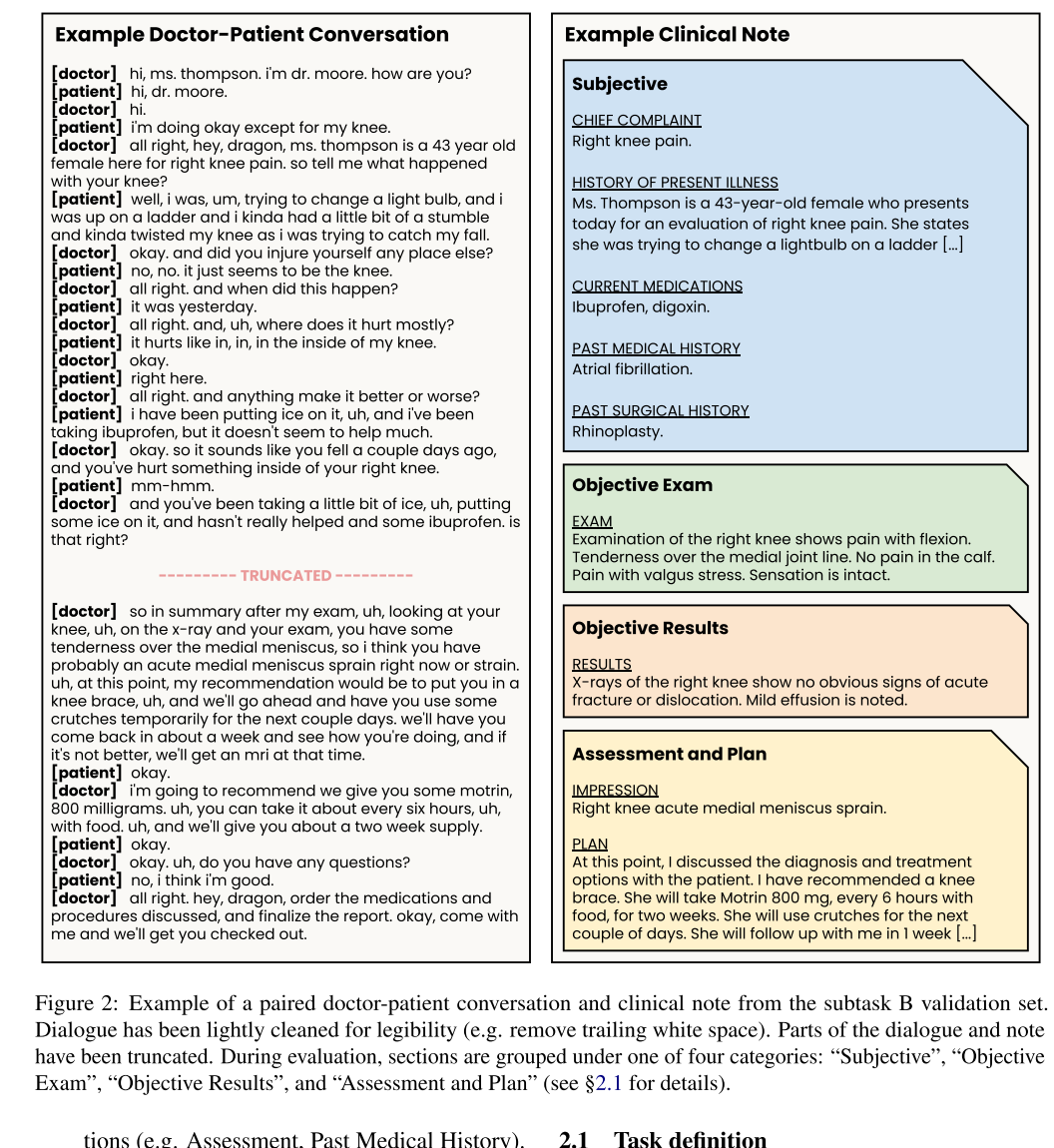

病历中包含一个或多个部分,比如如“主诉”和“家族史”,评估过程中,各部分被分为四个类别之一:Subjective、 Objective Exam、 Objective Results和Assessment and Plan,下图为医患对话和病历的的示例。

2.2 Dataset

该数据集包括67个训练和20个验证示例,以医生和病人相遇的转录对话和由此产生的临床医生写的笔记为特色。 每个示例都标有“数据集源”,表明用于生成笔记的对话转录系统

3 Approach

我们对共享任务采用两种高性能方法。首先,我们在所提供的训练集(§3.1)上微调一个预先训练的语言模型(PLM)。 在第二个方面,我们将上下文学习(ICL)与一个大型语言模型(LLM,§3.2)结合起来。

3.1 Fine-tuning pre-trained language models

作为第一种方法,我们在训练集上微调PLM遵循规范的、序列到序列的训练过程(图1a;有关详细信息,请参见附录C)。 给定输入对话的长度(图3),我们选择使用LongFormerEncoder-Decoder(LED,Beltagy et al.2020),其最大输入大小为16,384个令牌。 我们从PubMed总结数据集(Cohan et al.,2018)上调优的LEDLARGE检查点开始微调,该检查点在初步实验中表现最好。3该模型是在一个NVIDIA A100-40GB的GPU上使用HuggingFace Transformers(Wolf et al.,2020)微调的。 对验证集中的超参数进行了轻微调优。

3.2 In-context learning with LLMs

作为第二种方法,我们使用ICL尝试子任务B。我们选择GPT-4(OpenAI,2023)作为LLM,并设计了一个简单的提示符,其中包括自然语言指令和上下文示例(图4)。 我们将提示符大小限制在6192个令牌–允许2000个输出令牌,因为模型的最大令牌大小为8192–并使用了尽可能多的上下文示例,最多为3个。 我们将温度参数设置为0.2,并将OpenAI API的所有其他超参数设置为默认值。

自然语言指令

Prompt:Write a clinical note reflecting this doctor-patient dialogue. Use the example notes below to decide the structure of the clinical note. Do not make up information.

In-context example selection

每个上下文中的示例都是来自训练集的注释。 为了选择注释,我们首先嵌入每个训练示例的对话和输入对话。 然后根据与输入对话的余弦相似度对训练对话进行排序; 结果的top-k训练示例的注释被选择为上下文中的示例(参见图1,b)。 对话是使用支持自然语言教学的文本编码器讲师(Su et al.,2022a)嵌入的。6最后,我们限制上下文中的示例与输入对话属于相同的“数据集源”(参见§2.2),假设这可能会提高性能。

3.2 Evaluation

模型使用验证集中的官方评估脚本8进行评估(因为没有提供测试注释)。通过ROUGE (Lin, 2004)、BERTScore (Zhang et al., 2020)和BLEURT (Sellam et al., 2020)对生成的笔记与提供的地面真实笔记进行评估。我们报告的性能作为算术平均值的ROUGE-1 F1, BERTScore F1和BLEURT-20